L’accord Nvidia Groq 2025 fait couler beaucoup d’encre. Les gros titres parlent de rachat. Faux. Ce qui s’est passe en cette fin decembre 2025 est bien plus subtil qu’une simple transaction a 20 milliards de dollars – et ca va redefinir les regles du jeu de l’intelligence artificielle pour les annees a venir.

Groq avec un Q, pas Grok d’Elon Musk. Une startup encore meconnue du grand public mais qui fait trembler la Silicon Valley depuis des mois avec sa technologie d’inference ultra-rapide. Nvidia vient de s’y interesser de tres pres. Mais pas de la maniere dont on pourrait le croire.

Ce qu’est vraiment un acqui-hire et pourquoi Nvidia l’utilise

Contrairement a ce que les medias generalistes affirment, Groq n’a pas ete avale tout rond par le geant vert. Trois choses distinctes se sont produites simultanement.

Premierement, Nvidia a signe un accord de licence pour utiliser la technologie de Groq. Deuxiemement – et c’est la que tout se joue – Jonathan Ross, le fondateur, ainsi que ses meilleurs ingenieurs quittent le navire pour devenir employes de Nvidia. Troisiemement, l’entreprise Groq, la coquille juridique, continue d’exister de son cote.

Ce montage porte un nom tres specifique dans la vallee : l’acqui-hire. Un mot-valise anglais qui melange acquisition et hiring (recrutement). C’est comme si une ecurie de Formule 1 rachetait le moteur et les pilotes d’une ecurie concurrente mais laissait la voiture et le garage sur le bord de la piste.

Nvidia a preleve l’intelligence grise, le genie technique, tout en laissant la structure administrative derriere elle. Cette methode permet aux geants de recuperer les talents sans avoir a gerer les complications d’une fusion classique. Et surtout, ca permet souvent de passer sous les radars des regulateurs qui surveillent les monopoles. Malin, non ?

Entrainement vs inference : la guerre se deplace

Avant d’aller plus loin, il faut poser les bases. L’IA repose sur deux phases distinctes : l’entrainement et l’inference.

Imaginez un etudiant en medecine. L’entrainement, c’est ses 10 annees d’etudes. Il lit des milliers de livres, apprend par coeur l’anatomie. C’est long, ca coute tres cher, et on ne le fait qu’une fois. L’inference, c’est le moment ou cet etudiant est devenu medecin et qu’il est dans son cabinet. Un patient arrive, pose une question, et le medecin utilise ses connaissances pour donner un diagnostic.

Quand vous posez une question a ChatGPT, vous faites de l’inference.

Pourquoi je raconte ca ? Parce que le marche est en train de basculer. Jusqu’a present, la guerre se jouait sur l’entrainement – la creation des modeles. Maintenant, la bataille se deplace sur l’inference : l’utilisation massive de ces modeles par des milliards de personnes. Et pour faire de l’inference efficace, les besoins techniques sont completement differents.

C’est la que Groq entre en scene.

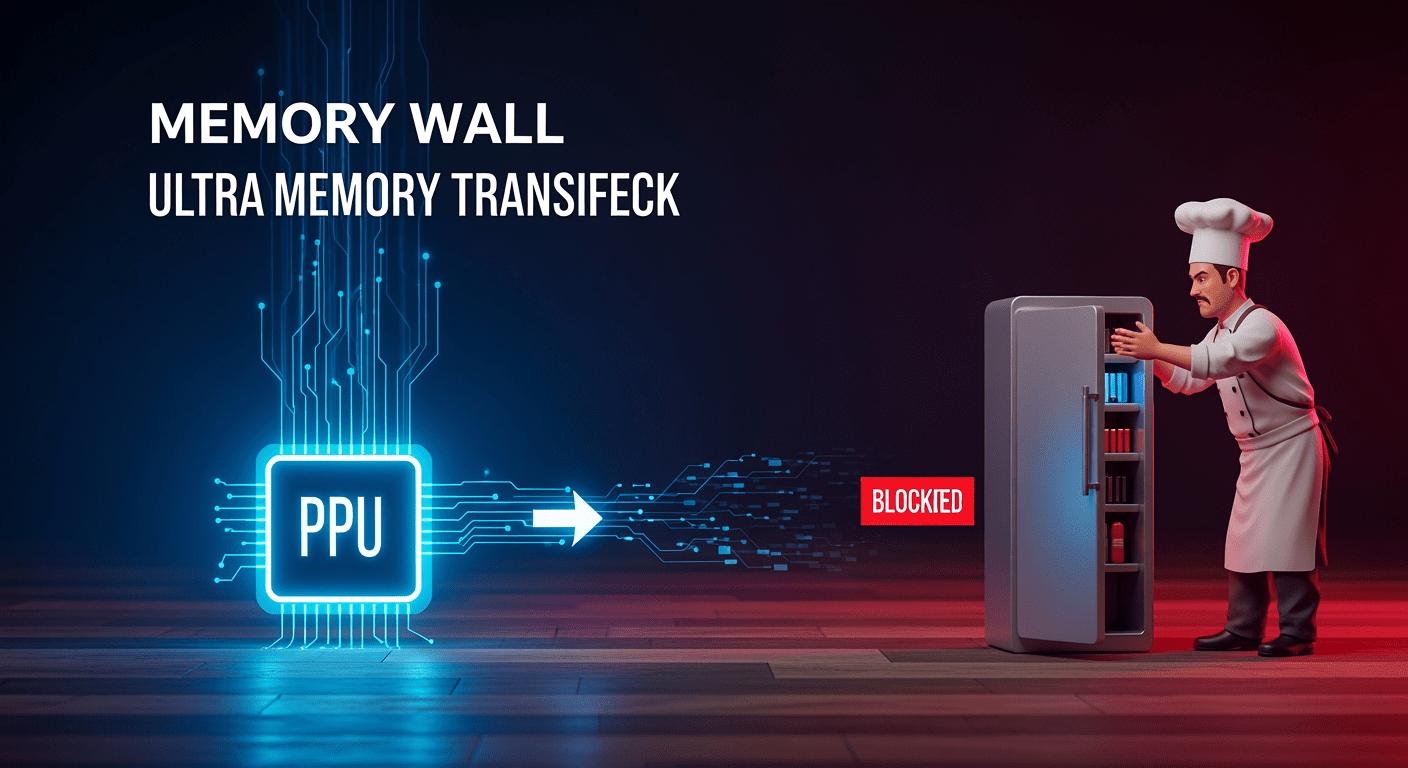

Le mur de la memoire : le vrai goulot d’etranglement de l’IA

Le probleme majeur de l’IA aujourd’hui, ce n’est plus la puissance brute. C’est la memoire. Les experts appellent ca le « mur de la memoire » (memory wall).

Imaginez un chef cuisinier etoile capable de couper des legumes a la vitesse de la lumiere. Ce chef, c’est le processeur. Mais imaginez que son frigo soit situe a l’autre bout du batiment. Il a beau etre le plus rapide du monde – s’il doit courir chercher chaque carotte une par une, il passera son temps a attendre.

C’est exactement ce qui se passe dans nos ordinateurs. Les puces calculent plus vite qu’elles ne peuvent recevoir les donnees. Les modeles d’IA modernes sont enormes. Ils deplacent des montagnes d’information en permanence. Si la memoire ne suit pas, l’intelligence artificielle ralentit.

Vous l’avez surement deja senti quand un chatbot met du temps a commencer sa phrase. Ce n’est pas qu’il reflechit – c’est souvent qu’il attend ses donnees.

L’industrie tente de resoudre ce probleme avec une technologie appelee HBM (memoire a haute bande passante). C’est comme si on installait un garde-manger geant juste a cote du plan de travail du chef. Efficace, mais extremement complexe a fabriquer – et il y a une penurie mondiale. Les carnets de commande sont pleins jusqu’en 2026. Comme on le voit avec les innovations de Nvidia sur NVLink Fusion, la bataille pour l’architecture des puces IA est feroce.

La technologie SRAM de Groq : 10 fois plus rapide que tout le reste

C’est ici que l’approche de Groq devient fascinante – et qu’on comprend pourquoi Nvidia s’y interesse autant.

Groq a regarde ce probleme de frigo et a dit : « Pourquoi mettre un garde-manger a cote ? Mettons les ingredients directement sur la planche a decouper, sous la main du chef. »

Techniquement, ils ont tout mise sur un type de memoire appele SRAM. Contrairement a la HBM qui est une puce separee collee a cote du processeur, la SRAM est une memoire integree directement a l’interieur de la puce de calcul.

La difference de vitesse est hallucinante. Groq revendique des vitesses de transfert dix fois superieures aux meilleures technologies actuelles. C’est la difference entre aller chercher un livre dans la bibliotheque du quartier ou avoir l’information qui apparait instantanement dans votre cerveau.

Grace a cette technologie, Groq proposait des puces capables de generer du texte instantanement, sans aucune latence. Pour des assistants vocaux avec qui on veut discuter naturellement, c’est le Graal.

Mais alors, si c’est si genial, pourquoi tout le monde ne fait pas ca ? Parce qu’il y a un piege. La memoire SRAM prend une place physique enorme. C’est comme l’immobilier en centre-ville : tres pratique mais ca coute une fortune au metre carre et on manque vite de place.

Les montages financiers SPV : quand les puces deviennent des actifs bancaires

Aspect souvent ignore mais passionnant : l’argent. Pas juste le prix, mais la structure financiere.

L’IA coute cher. Des milliards de dollars. On voit emerger des montages financiers inedits. Prenez l’exemple d’Elon Musk avec sa societe xAI. On entend dire qu’il cree des SPV (Special Purpose Vehicle). En francais, on appelle ca un « vehicule a usage special ».

C’est un peu comme une SCI quand vous achetez un appartement pour le louer. Au lieu que l’entreprise xAI s’endette directement, elle cree une boite vide – ce fameux SPV – qui va emprunter de l’argent pour acheter les puces Nvidia. Ensuite, ce SPV loue la puissance de calcul a xAI.

Pourquoi faire si complique ? Parce que ca transforme les puces informatiques en actif financier, exactement comme de l’immobilier. Les banques sont rassurees car elles financent un actif tangible qui rapporte un loyer. On retrouve des mecanismes similaires avec la dette colossale d’OpenAI qui depasse les 300 milliards de dollars en engagements.

Nvidia participe meme parfois a ce systeme en investissant dans ces vehicules. C’est un cercle ou la finance permet de verrouiller l’approvisionnement en materiel. Fascinant de voir que pour gagner la course a l’IA, il faut etre aussi bon en design de processeur qu’en ingenierie bancaire.

Ce que ca change pour vous en 2026

Ce deal Nvidia-Groq envoie des signaux clairs sur ce qui va avoir de la valeur en 2026.

Si vous etes developpeur ou ingenieur, arretez de vous obseder sur l’entrainement de modeles geants. La bataille se deplace vers l’optimisation. Groq nous a montre que la vitesse change l’usage. Les entreprises ne cherchent plus seulement l’intelligence – elles cherchent la fluidite et le cout reduit. Interessez-vous aux techniques qui allegent les modeles comme la quantisation ou la distillation. Apprenez comment faire tourner un modele localement sur du petit materiel. C’est la que la demande explose.

Si vous etes product manager ou decideur, la lecon de Groq c’est que la latence est une fonctionnalite a part entiere. Les utilisateurs pardonnent une reponse un peu moins intelligente si elle est instantanee, mais ils abandonnent une application qui mouline pendant 5 secondes. Si votre chatbot met plus d’une seconde a repondre, vous avez un probleme d’architecture, pas de prompt.

Si vous etes consultant ou en strategie, regardez la structure du deal. Nvidia n’a pas achete l’entreprise. Ils ont achete les 10 personnes qui comprennent le systeme entier. La valeur n’est plus dans le fait de savoir utiliser l’IA, mais de comprendre comment le logiciel parle au materiel. Ne soyez pas celui qui vend juste du prompt. Soyez celui qui explique a ses clients la difference de cout entre une solution cloud et une solution locale.

Le futur appartient a ceux qui voient le systeme dans son ensemble – de la puce memoire jusqu’a l’interface utilisateur. C’est ca, avoir un coup d’avance. Et comme on le voit avec les avancees sur l’informatique quantique et l’IA, les prochaines annees vont etre vertigineuses.

Tuto comment utiliser son twitch prime et soutenir le site gratuitement.

Trouve des groupes avec qui jouer sur notre discord !

Ou plus simplement pour faire avancer le site Kami-labs.fr abonne toi a ma chaine YouTube ! Merci <3